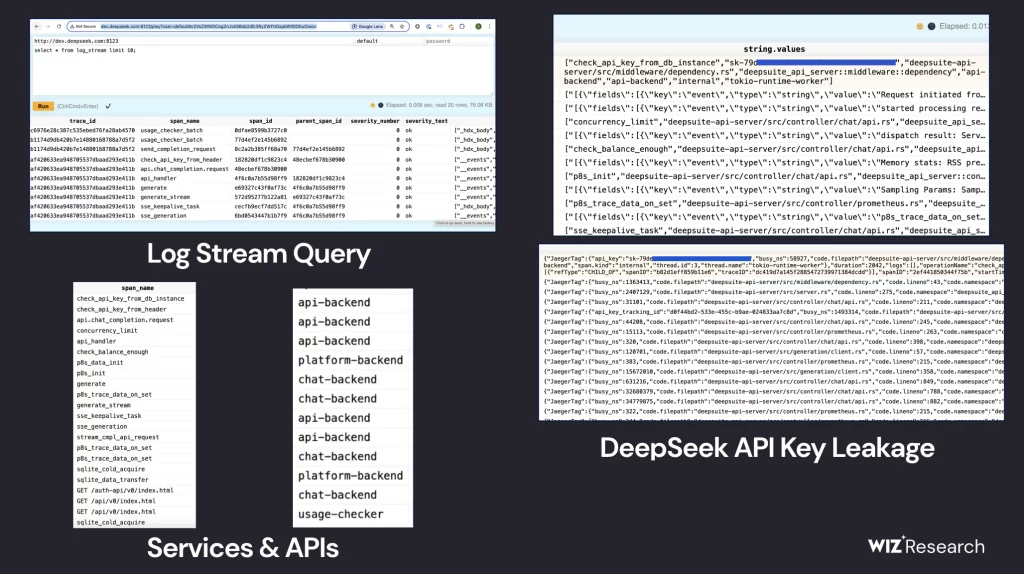

L’essor fulgurant de l’intelligence artificielle (IA) a mis en lumière des enjeux de sécurité sans précédent. Récemment, la startup chinoise DeepSeek s’est retrouvée au cœur d’une controverse après qu’une base de données non sécurisée ait été découverte, exposant des informations sensibles. Selon une enquête menée par Wiz Research, cette faille a permis un accès non authentifié à plus d’un million de lignes de logs, contenant des historiques de conversation, des clés API et d’autres métadonnées critiques.

Une base de données accessibles sans authentification

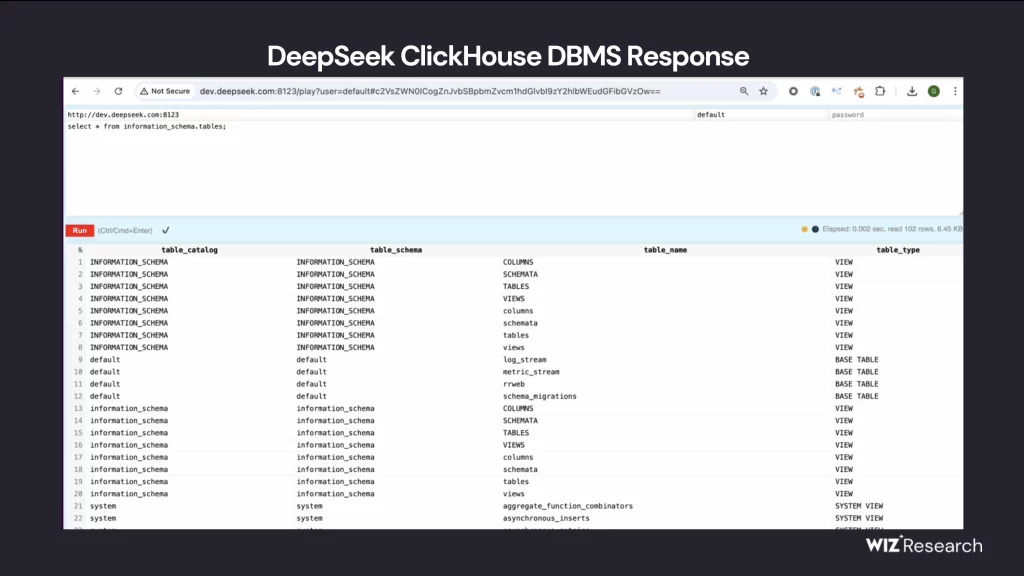

L’équipe de Wiz Research a identifié une base de données ClickHouse accessible publiquement et hébergée sur les domaines oauth2callback.deepseek.com:9000 et dev.deepseek.com:9000. Cette base offrait un contrôle total des opérations de base de données sans aucune authentification, ce qui aurait permis à des acteurs malveillants d’exécuter des requêtes SQL arbitraires et d’exfiltrer des données sensibles.

Données exposées

Parmi les informations exposées figuraient :

- Historiques de conversation des utilisateurs de DeepSeek

- Clés secrètes et informations backend

- Métadonnées opérationnelles

- Logs contenant des identifiants d’API en clair

Ces données auraient pu être exploitées pour escalader les privilèges au sein de l’environnement DeepSeek, compromettant ainsi la sécurité des systèmes et des utilisateurs.

Une découverte alarmante

Méthodologie de l’Enquête

Les chercheurs ont commencé leur investigation par une analyse de la surface d’attaque externe de DeepSeek. En cartographiant les sous-domaines publics, ils ont identifié environ 30 sous-domaines accessibles sur Internet. Si la plupart semblaient anodins (interface chatbot, documentation API, etc.), deux ports inhabituels (8123 et 9000) ont attiré leur attention.

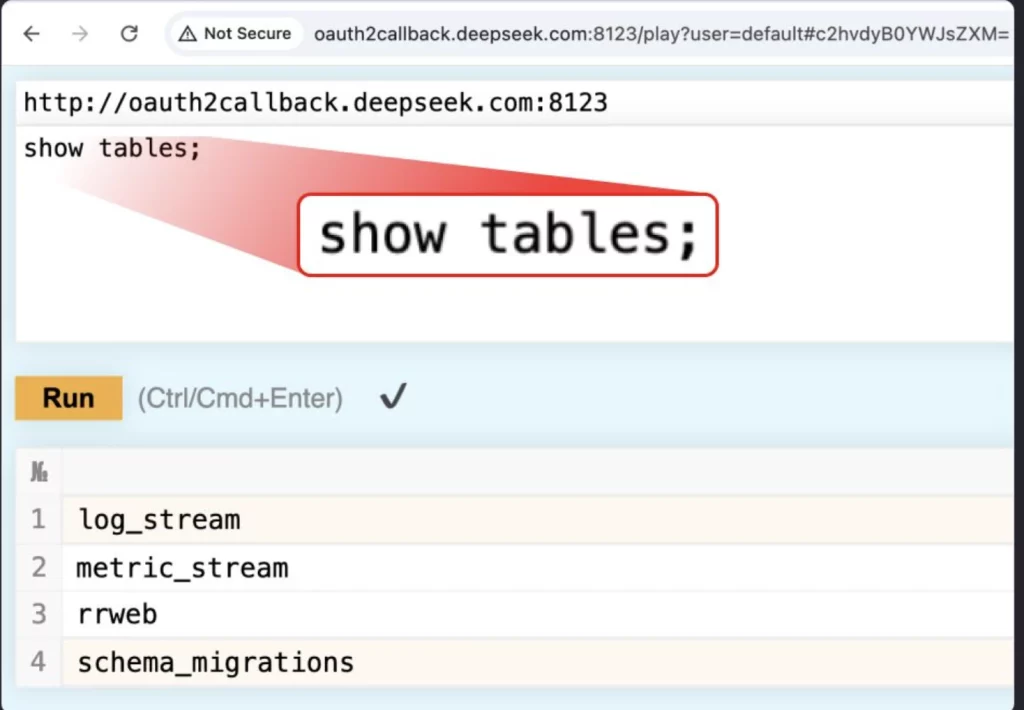

L’exploration de ces ports a permis d’accéder à l’interface HTTP de ClickHouse, une base de données conçue pour le traitement rapide de grandes quantités de données analytiques. En exécutant une simple requête SHOW TABLES;, les chercheurs ont pu récupérer une liste complète des tables accessibles, dont log_stream, contenant des logs très sensibles.

Exfiltration de Données

Une fois la liste des tables obtenue, les chercheurs ont exécuté plusieurs requêtes SQL permettant d’extraire des échantillons de données. Ils ont ainsi découvert que les logs contenaient non seulement des conversations utilisateurs, mais aussi des identifiants de session et des jetons d’authentification stockés en clair.

L’absence de chiffrement des données sensibles et de contrôles d’accès granulaires a facilité l’accès à des informations critiques. Cette faille aurait pu être exploitée pour :

- Déchiffrer les communications privées entre utilisateurs et l’IA,

- Obtenir des accès non autorisés à d’autres services internes de DeepSeek,

- Simuler des requêtes authentifiées en utilisant les clés exposées.

Risques associés

Les conséquences d’une telle exposition sont multiples :

- Fuite de données utilisateurs : Des acteurs malveillants auraient pu extraire et analyser les historiques de conversation.

- Accès à des infrastructures critiques : Les clés API exposées auraient pu permettre des intrusions dans d’autres systèmes internes.

- Risques de cyberattaques : Des attaquants auraient pu utiliser ces informations pour mener des attaques ciblées (phishing, ransomwares, etc.).

- Non-conformité aux réglementations : L’exposition de telles données pourrait entraîner des sanctions légales et réglementaires pour DeepSeek.

- Manipulation des modèles d’IA : Les attaquants auraient pu utiliser ces accès pour injecter des biais dans les modèles, modifiant ainsi leur comportement.

| Risque | Conséquence |

|---|---|

| Fuite de données | Exposition d’informations personnelles et sensibles |

| Intrusion dans les infrastructures | Accès non autorisé à des systèmes critiques |

| Cyberattaques | Augmentation des risques de phishing et ransomwares |

| Problèmes légaux | Violation des normes RGPD et autres réglementations |

| Altération des modèles d’IA | Manipulation des réponses générées par l’IA |

Une prise de conscience nécessaire

Le cas DeepSeek illustre les risques inhérents à l’adoption rapide de l’IA sans mesures de sécurité adéquates. Les entreprises doivent :

- Adopter une approche « Security by Design » : Intégrer la sécurité à chaque étape du développement des systèmes IA.

- Réaliser des audits de sécurité réguliers : Identifier et corriger les vulnérabilités avant qu’elles ne soient exploitées.

- Mettre en place des contrôles d’accès stricts : Restreindre l’accès aux bases de données sensibles aux seuls utilisateurs autorisés.

- Sensibiliser les équipes : Les ingénieurs IA et les responsables sécurité doivent collaborer pour renforcer la protection des données.

- Utiliser des mécanismes de chiffrement avancés : Les données sensibles doivent être stockées et transmises de manière sécurisée.

- Mettre en place des systèmes de surveillance active : Une détection précoce des accès anormaux aurait pu limiter les dommages.

Le précédent DeepSeek : Une leçon pour l’industrie

Ce n’est pas la première fois qu’une entreprise spécialisée en IA se retrouve exposée à de telles failles. D’autres sociétés, y compris des géants du secteur, ont déjà subi des fuites de données liées à des erreurs de configuration.

L’incident souligne l’importance d’adopter une stratégie de sécurité proactive, en appliquant des bonnes pratiques DevSecOps et en mettant en œuvre des tests d’intrusion réguliers. L’industrie de l’IA ne peut plus se permettre de traiter la cybersécurité comme une simple formalité.

La fuite de données de DeepSeek est un rappel brutal que les risques liés à la sécurité des IA ne sont pas seulement théoriques mais bien réels. Si les menaces futures de l’IA suscitent de nombreuses inquiétudes, les dangers actuels résident souvent dans des erreurs de configuration bénignes mais catastrophiques. Assurer la protection des données des utilisateurs doit rester une priorité absolue pour les startups et les entreprises exploitant l’IA.